Notice

Recent Posts

Recent Comments

Link

Douglas' Space

하이퍼 파라미터(Hyper Parameters) 란? 본문

딥러닝에서 파라미터(parameters)라 하면 일반적으로 학습에 의해 조정되는 모델 내부의 파라미터만을 의미합니다. 보통 인공뉴런이 연결되는 링크에 부여된 가중치와 바이어스 값을 말합니다. 이 파라미터와 구분하여 상대적으로 지칭하는 것이 하이퍼 파라미터(hyper parameters)입니다. 하이퍼 파라미터는 파라미터와 구분하여 사용자가 딥러닝을 위해 설정하는 값들을 모두 지칭합니다.

따라서 하이퍼 파라미터는 모델의 종류에 따라 다양한 파라미터가 존재합니다. ANN의 구조를 결정하는 계층의 수, 각 계층의 뉴런의 개수 등이 모두 하이퍼 파라미터입니다. 추가로 향후 이해를 위해 기억해야 할 중요 하이퍼 파라미터를 소개하면 다음과 같습니다.

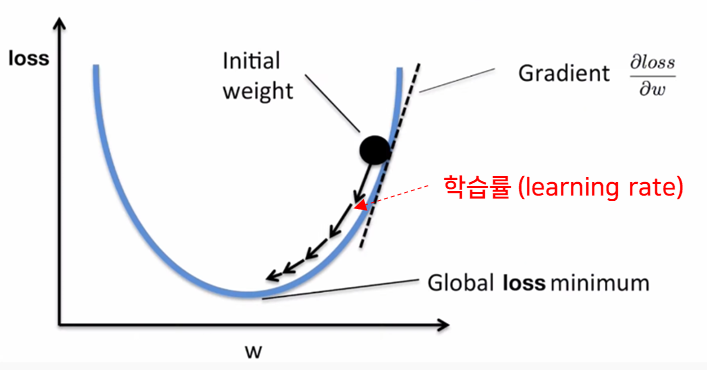

학습률(learning rate)

학습이란 손실함수(정답과 예측한 값과의 차이를 계산한 함수)를 최소화하는 파라미터를 찾는 것과 같다고 하였습니다. 아래와 같이 손실함수의 포물선을 따라 아래로 이동하면서 가중치 w에 대한 손실함수의 미분값이 0이 되는 지점을 찾는데(이러한 방법을 경사하강법이라 함), 이때 경사를 따라 이동하는 양을 학습률이라고 합니다.

에폭(epoch)

epoch이란 모델이 학습 데이터셋 전체에 대해 학습을 완료한 상태를 의미합니다. 다시말해 epoch은 학습 데이터 전체를 의미한다고 할 수 있습니다. 따라서 epoch의 수는 학습을 종료할 때까지의 epoch의 횟수를 의미합니다. (학습을 위해 보통 학습 데이터셋을 여러번 실행하여 학습을 합니다.)

배치(batch)

모든 데이타를 한번의 처리하지 않고 메모리 및 성능을 고려하여 에폭을 작은 데이터 셋으로 나누어 수행하는 데 이를 배치 또는 미니배치(mini batch)라고 합니다. 이 배치를 구성하는 데이타 샘플의 수를 배치사이즈라고 합니다.

반복(iterations) 또는 스탭(steps)

에폭을 배치사이즈로 나눈 값으로 미니배치의 개수로서, 보통 하나의 배치단위로 파라미터를 갱신(역전파)하기 때문에 파라미터의 갱신의 횟수를 의미하기도 한다.

옵티마이저(optimizer)

학습의 과정은 입력값으로 출력을 계산하는 순전파(forward propagation)와 파라미터를 갱신하는 역전파(backward propagation)를 반복적으로 수행합니다. 학습을 실제로 수행하는 프로그램을 옵티마이저라고 합니다. 옵티마이저는 이러한 학습 과정을 수행하는 방법에 따라 여러 종류가 존재합니다. (가장 많이 사용하는 일반적인 옵티마이저로서 Adam optimizer가 있습니다.)

'Computing Tech. Diary > Artificial Intelligence' 카테고리의 다른 글

| CNN 신경망을 통해 이해하는 딥러닝 (0) | 2022.04.28 |

|---|---|

| 데이타가 없으면 AI시스템을 개발할 수 없는가? (0) | 2022.04.28 |

| ANN기반의 인공지능시스템 개발 방법론 (0) | 2022.04.28 |

| 인공지능이 그림을 그린다구요? (0) | 2022.04.28 |

| 활성화함수(activation function)에 대하여 (0) | 2022.04.28 |

Comments