Douglas' Space

분류 모델(Classification Model)의 평가 지표 본문

분류 모델(Classification Model)의 평가 지표

똘키아빠 2024. 11. 24. 23:13이번에는 분류모델에 대한 평가지표들을 알아보도록 하겠습니다. 평가지표를 알아보기 위해 먼저 평가를 위한 데이타를 분류하기 위한 분류표인 Confusion Matrix(혼동행렬)에 대해 알아 보도록 하겠습니다.

1. Confusion Matrix (혼동행렬)

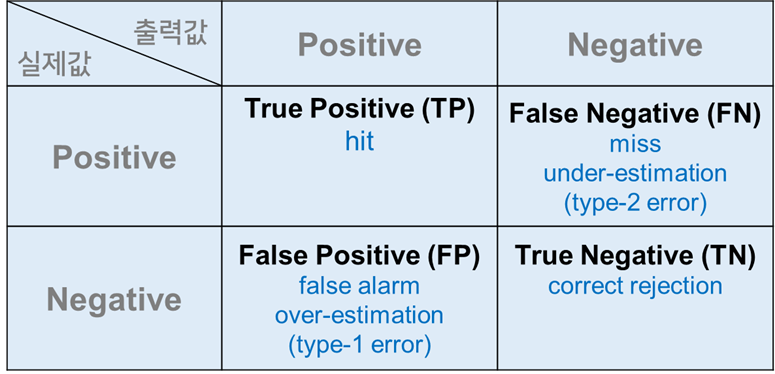

아래 그림은 Confusion Matrix(혼동행렬)를 설명하는 표로, 머신러닝 및 통계 분석에서 모델의 성능 평가를 위해 자주 사용됩니다. 혼동 행렬은 예측값(출력값)과 실제값의 조합을 비교하여 모델이 얼마나 정확히 분류했는지 분석하는 데 사용됩니다.

- True Positive (TP): 모델이 양성(Positive)이라고 예측했고, 실제로도 양성인 경우. (예: 암 진단 모델이 암이 있는 환자를 올바르게 암으로 예측한 경우)

- False Positive (FP): 모델이 양성(Positive)이라고 예측했지만, 실제로는 음성(Negative)인 경우. (예: 암 진단 모델이 암이 없는 환자를 암으로 잘못 진단한 경우)

- False Negative (FN): 모델이 음성(Negative)이라고 예측했지만, 실제로는 양성(Positive)인 경우. (예: 암 진단 모델이 암이 있는 환자를 암이 없다고 잘못 판단한 경우.)

- True Negative (TN): 모델이 음성(Negative)이라고 예측했고, 실제로도 음성인 경우. 예: 암 진단 모델이 암이 없는 환자를 올바르게 암이 없다고 판단한 경우.)

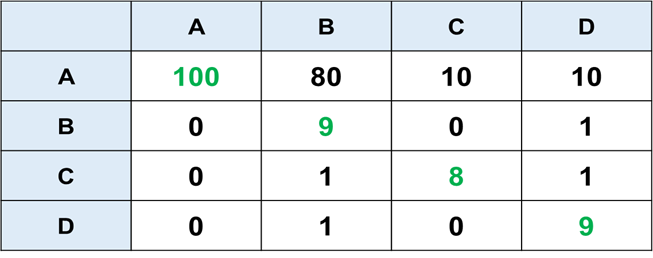

아래 그림은 이 Confusion Matrix의 한 예를 보여주는 표입니다. A, B, C, D라는 4가지의 종류를 분류하는 모델에서 시험데이터를 활용하여 실제값과 예측값의 결과를 집계한 Confusion matrix를 나타내고 있습니다.

첫번째 행이 의미는 이 모델이 A를 A라고 맞춘 경우가 100개이고, 나머지는 A가 아니라 B, C, D로 각각 80, 10, 10개 잘못 맟춘 경우를 보여주고 있습니다.

2. Consution Matrix에 따른 평가지표들

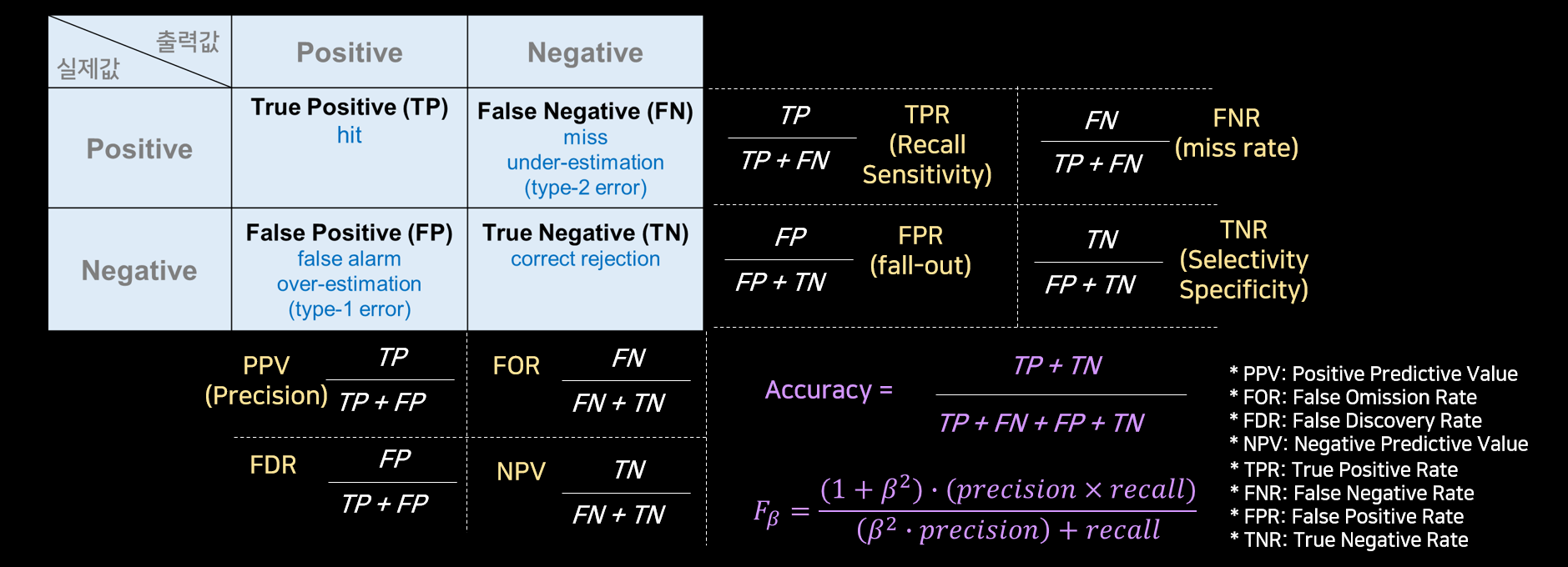

아래 그림은 위의 Confusion Matrix를 기준으로 다양한 분류에 대한 평가지표들을 나타내고 있습니다.

가장 일반적이며 전체적인 상황을 사용하는 지표는 보라색으로 기술된 Accuracy(정확도)와 Fβ입니다. 특히 Fβ의 경우는 Precision(정밀도)과 Recall(재현율)의 가중치를 동일하게 하는 β =1인 F1-Score입니다. 모델에 따라 한 종류에 치중되는 불균형데이타를 사용하여 학습된 모델을 평가하는 경우 정확도가 모델의 특성을 반영하기 어려운 경우 F1-Score를 사용하게 됩니다.

- TPR(True Positive Rate, Recall, Sensitivity): 재현율 또는 민감도라고 하며, 실제 양성중에서 모델이 양성이라고 예측한 비율(예: 암환자를 암 환자로 진단한 비율)

- FNR(False Negative Rate, Miss Rate): 누락율이라고 하며, 실제 양성 중에서 모델이 음성으로 잘못 예측한 비율 (예, 암 환자를 놓친 비율)

- FPR (False Positive Rate, Fall-out): 오경보율이라고 하며, 실제 음성 중에서 모델이 양성으로 잘못 예측한 비율 ( 건강한 사람을 암으로 잘못 진단한 비율)

- TNR (True Negative Rate, Specificity, Selectivity): 특이도 또는 선택도라고 하며, 실제 음성 중에서 모델이 음성을 잘 예측한 비율 ( 건강한 사람을 정확히 진단한 비율)

- PPV(Positive Preditive Value, Precision): 정밀도라고 하며, 양성 예측이 실제 양성일 확률 ( 예: 암으로 예측된 사람 중 실제로 암인 비율)

3. AUC(Area Under ROC Curve)

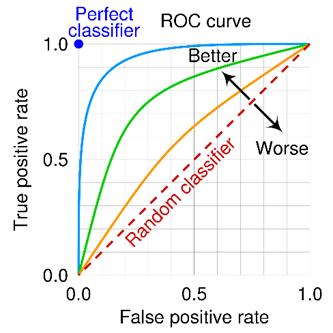

AUC는 ROC (Receiver Operating Characteristic) Curve 아래의 면적을 의미하며, 이진 분류 모델의 성능을 평가하는 중요한 지표입니다. AUC는 0과 1 사이의 값을 가지며, 모델이 양성(Positive) 클래스와 음성(Negative) 클래스를 얼마나 잘 구분하는지를 나타냅니다.

이 그림은 ROC Curve를 나타내며 그 의미는 FPR(오경보율)과 TPR(재현율)의 변화에 따른 그래프로서 FPR이 증가할 때 TPR의 값의 변화를 나타냅니다. 양성의 판단이 이산적으로 결정되지 않고 연속적인 값을 갖는 경우 양성의 판정에 대한 판정이 임계치에 따라 다르게 해석되게 됩니다. 이 임계치에 따른 양성판정이 달라지면 Confusion Matrix가 임계치에 따라 다르므로 평가지표들이 변화하게 됩니다.

ROC Curve는 제2차 세계대전 중에 레이더 신호를 분석하기 위해 처음 도입되었습니다. 이 곡선은 원래 신호 감지 이론 (Signal Detection Theory)에 뿌리를 두고 있으며, 신호(예: 적군의 비행기)를 배경 잡음(예: 바람 소리, 기계 소음)과 구별하는 문제를 다루기 위해 고안되었습니다. 여기서의 Receiver는 바로 레이다수신기를 의미합니다.

AUC는 ROC Curve의 아래 면적을 의미하며 이 면적이 클수록 이진분류기의 성능이 우수함을 의미합니다. 위 그림에서 AUC가 1인 경우가 가장 이상적인 이진분류기입니다. 0.5는 Random분류기로서 0.5보다 클수록 좋은 분류기이고 0.5보다 작은 경우는 성능이 매무 좋지 않은 분류기를 의미합니다.

'Computing Tech. Diary > Artificial Intelligence' 카테고리의 다른 글

| Google의 Agent2Agent (A2A) 프로토콜 (1) | 2025.04.13 |

|---|---|

| 모델 컨텍스트 프로토콜(MCP): AI 통합의 새로운 표준과 미래 전망 (0) | 2025.04.13 |

| 회귀 모델(Regression Model)의 평가지표 (0) | 2024.11.23 |

| chatGPT에 대해서 (2) | 2023.03.25 |

| ANSR Program (0) | 2022.10.20 |