Notice

Recent Posts

Recent Comments

Link

Douglas' Space

RouterDC: 듀얼 대비 학습을 통한 쿼리 기반 라우터 본문

Computing Tech. Diary/Artificial Intelligence

RouterDC: 듀얼 대비 학습을 통한 쿼리 기반 라우터

똘키아빠 2025. 6. 13. 10:17RouterDC는 "Query-Based Router by Dual Contrastive learning"의 줄임말입니다. 이 혁신적인 방법론은 여러 대규모 언어 모델(LLM)의 강점을 효율적으로 결합하기 위해 제안되었으며, 특정 쿼리에 가장 적합한 LLM을 동적으로 선택하는 "라우터" 역할을 수행합니다. 이 개념은 Shuhao Chen, Weisen Jiang, Baijiong Lin, James T. Kwok, Yu Zhang 연구진에 의해 최초로 제안되었습니다.

1. RouterDC의 배경 및 개발 동기

- LLM 앙상블의 부상: 최근 연구들은 여러 대규모 언어 모델(LLM)을 조합함으로써 그들의 상호 보완적인 능력을 활용할 수 있음을 보여주고 있습니다. 이러한 접근 방식은 개별 LLM의 한계를 극복하고 더 강력한 성능을 달성할 수 있게 합니다.

- 라우팅 방법의 중요성: LLM 앙상블의 효과를 극대화하기 위해 각 쿼리에 가장 적합한 LLM을 선택하는 '라우팅' 기법이 유망한 방법으로 대두되었습니다. 이는 다양한 LLM의 특성을 고려하여 최적의 경로를 찾아주는 핵심적인 역할을 합니다.

- 기존 라우팅의 한계와 RouterDC의 탄생: 하지만, 기존의 라우팅 모델들은 여러 LLM이 하나의 쿼리에 대해 모두 좋은 성능을 보일 때, 최적의 LLM을 효율적으로 선택하는 데 어려움을 겪는다는 문제점이 있었습니다. 이러한 한계를 해결하고, LLM 조합의 성능을 한층 더 끌어올리기 위해 듀얼 대비 학습(Dual Contrastive learning) 기반의 쿼리 기반 라우터인 RouterDC가 제안되었습니다.

2. RouterDC의 구성 요소

RouterDC 모델은 크게 두 가지 핵심 구성 요소로 이루어져 있습니다.

- 인코더 (): 입력된 쿼리()를 이해하고 이를 기반으로 임베딩 벡터를 생성합니다. 이 임베딩은 쿼리의 의미론적 정보를 담고 있습니다.

- LLM 임베딩 (): 각 개별 LLM()을 대표하는 임베딩 벡터입니다. 이 임베딩은 해당 LLM의 특성과 강점을 나타냅니다.

3. 학습 방법: Dual Contrastive Learning

RouterDC 모델은 다음 두 가지 대비 학습 손실(loss)을 사용하여 학습됩니다.

- 첫 번째 대비 학습 손실: 쿼리 임베딩과 가장 적합한 LLM 임베딩 사이의 유사성을 높이고, 부적합한 LLM 임베딩과의 유사성은 낮추도록 학습합니다.

- 두 번째 대비 학습 손실: LLM 임베딩 자체를 쿼리 공간에 맞게 정렬하여, 유사한 쿼리에 잘 맞는 LLM들은 서로 가깝게 위치하도록 학습합니다.

이러한 듀얼 대비 학습을 통해 RouterDC는 쿼리와 LLM 간의 관계를 효과적으로 학습하고, 주어진 쿼리에 대한 최적의 LLM을 정확하게 식별할 수 있게 됩니다.

4. 성능 및 장점

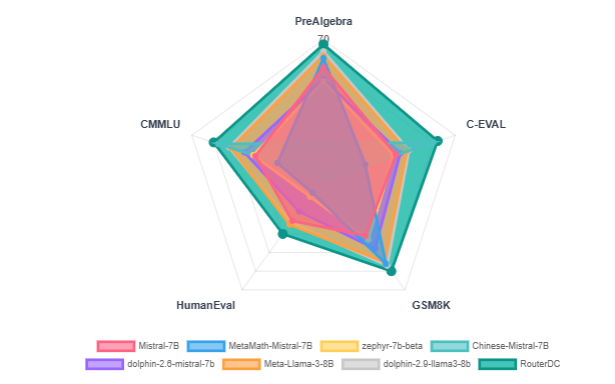

RouterDC는 실험 결과 다음과 같은 뛰어난 성능을 보였습니다.

- 개별 LLM 및 기존 라우팅 방법 능가: 개별적으로 가장 높은 성능을 보이는 LLM들뿐만 아니라, 기존의 LLM 라우팅 방법보다도 전반적으로 우수한 성능을 달성했습니다.

- 배포 내(In-Distribution) 작업 향상: 학습 데이터와 유사한 작업에서 약 $2.76%$의 성능 향상을 보여주었습니다.

- 배포 외(Out-of-Distribution) 작업 향상: 학습 데이터와 다른 새로운 작업에서도 약 $1.90%$의 성능 향상을 보여, 일반화 능력이 뛰어남을 입증했습니다.

결론적으로, RouterDC는 LLM 조합을 위한 강력하고 효과적인 라우팅 솔루션으로, 특히 여러 LLM의 장점을 활용하여 복잡한 쿼리에 대한 응답 품질을 향상시키는 데 기여합니다.

'Computing Tech. Diary > Artificial Intelligence' 카테고리의 다른 글

| Google의 Agent2Agent (A2A) 프로토콜 (1) | 2025.04.13 |

|---|---|

| 모델 컨텍스트 프로토콜(MCP): AI 통합의 새로운 표준과 미래 전망 (0) | 2025.04.13 |

| 분류 모델(Classification Model)의 평가 지표 (0) | 2024.11.24 |

| 회귀 모델(Regression Model)의 평가지표 (0) | 2024.11.23 |

| chatGPT에 대해서 (2) | 2023.03.25 |

Comments