Notice

Recent Posts

Recent Comments

Link

Douglas' Space

음성인식 및 합성 기술 본문

딥러닝 기반의 인공지능이 다루는 데이타는 텍스트, 그래픽, 이미지, 동영상, 오디오 등이 있습니다. 이를 멀티미디어 데이타라고 합니다. 지금까지 주로 텍스트, 그래픽, 이미지 및 동영상과 관련된 기술에 대해 설명드렸습니다. 이번 시간부터는 오디오와 관련된 음성처리기술에 대해 정리해 보고자 합니다. 특히 사람과의 대화가 가능하도록 하는 음성인식 및 합성 기술에 대해 살펴보도록 하겠습니다.

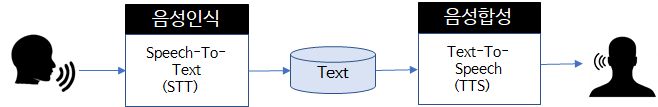

음성인식은 사람이 말하는 음성을 텍스트로 변환하는 기술이라고 할 수 있습니다. 따라서 이를 기술적으로는 Speech-To-Text(STT)라고 부릅니다. 반대로 음성합성은 텍스트를 음성으로 변환하는 기술로 Text-To-Speech(TTS)라고 할 수 있습니다.

음성인식을 위해서는 먼저 사람의 음성이 아날로그이기 때문에 컴퓨터에서 처리하기 위해 디지털로 변환을 하는 신호처리과정을 먼저 수행해야 합니다. 이를 위해서는 waveform으로 표현되는 아날로그 신호를 sampling과 quantization을 통해 디지털로 변환해야 합니다. 이렇게 하여 컴퓨터가 처리할 수 있는 디지털값으로 음성신호를 변환합니다.

위 그림에서 파란색의 아날로그 신호를 적색 간격으로 데이타의 샘플을 수치화하는 것을 샘플링이라 하고, 샘플링 할때 취하는 값의 정밀함, 즉 데이타의 스텝의 크기에 따라 데이타를 수치화하는 것을 qauntization(양자화)이라고 합니다. 따라서 샘플링 횟수와 양자화의 정도가 데이타의 크기와 음성정보의 품질을 좌우하게 됩니다.

이렇게 변환된 데이터를 이용하여 딥러닝 모델의 입력으로 사용하는 경우는 크기가 크고 다루기가 용이하지 않습니다. 따라서 음성의 특징 만을(주파수대역으로 변환한 spectrum을 시간프레임으로 통합한 spectrogram) 추출하여 모델의 입력데이타로 활용합니다. 기존의 음성인식은 다양한 블럭으로 구성이 되었지만 현재는 딥러닝모델을 이용하여 End-to-end 모델이라는 개념으로 바로 인식한 음성의 텍스트를 출력합니다. (아래그림)

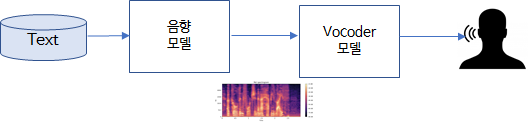

음성합성모델은 음성인식과 반대로의 모델이므로 text를 입력받아 이에 대응되는 음성특징정보인 spectogram을 생성하고, 이를 기반으로 최종 음성을 발화하는 vocorder라는 모델을 통해 최종 음성을 출력하게 됩니다. (아래그림)

특히 음성합성에서의 음향모델은 음성특징정보인 sepectogram을 어떻게 생성하는냐에 따라 다양한 음성이 출력될 수 있습니다. 음성인식과 음성합성의 경우는 디지털휴먼을 구축하는 매우 중요한 기술입니다. 따라서 다음에는 이러한 디지털휴먼을 구현하기 위한 음성인식 및 음성합성에 대한 이야기를 좀더 기술적으로 기술하도록 하겠습니다.

'Computing Tech. Diary > Artificial Intelligence' 카테고리의 다른 글

| 50파운드 영국지폐의 비밀 (0) | 2022.08.11 |

|---|---|

| 화자인식기술 (0) | 2022.07.10 |

| 차원 축소(Dimensionality Reduction)에 대해 (0) | 2022.05.07 |

| Federated Learning vs. Distributed Learning (0) | 2022.05.02 |

| Deep Metric Learning (0) | 2022.05.02 |

Comments